Una tarjeta de red codifica y transmite la información como ceros y unos. Un disco duro o una tarjeta de memoria almacena vídeo, sonido, fotografía como ceros y unos. Y también el microprocesador de tu ordenador manipula así los datos. Pero ¿por qué precisamente ceros y unos? ¿Acaso no se podía representar la información de una manera más humana?

Símbolos e ideas humanos

Pensemos en una taza de té caliente. Esta idea puede ser concreta (el té negro que bebo ahora en mi taza de porcelana) o abstracta (cualquier tipo de té en cualquier tipo de taza). Concreto o abstracto, es un concepto que se puede representar a través del lenguaje escrito (o hablado).

La idea «una taza de té caliente» se puede representar con lenguaje hablado o escrito.

La idea «una taza de té caliente» se puede representar con lenguaje hablado o escrito.

Todo claro hasta aquí. Evidentemente podemos referirnos a una taza de té usando unas pocas palabras. Y los símbolos que escribiremos dependen del idioma que usemos. El conjunto de símbolos que un idioma usa para representar los sonidos en el papel es el alfabeto.

El alfabeto latino, usado por las lenguas inglesa y española, tiene 28 letras. El alfabeto cirílico, usado en el idioma ruso, tiene 33 letras. Pero no todas las lenguas son alfabéticas. Por ejemplo, el chino o el japonés poseen miles de caracteres.

En cualquier caso, lo que debemos tener claro es que el concepto «taza de té caliente» se puede escribir con más o menos palabras, con más o menos sílabas, con más o menos símbolos. Es decir, la misma información se puede representar de forma simple o compleja.

Pero para un ordenador la aparente simplicidad del alfabeto latino es demasiado compleja.

En los límites de la electricidad

Aunque complejo, un ordenador no es más que un dispositivo electrónico. Lo que corre por sus cables y circuitos es, en definitiva, un flujo de electrones, vamos, una corriente eléctrica. Sí, en el fondo, una computadora no deja de ser una máquina eléctrica.

Y la electricidad se manipula con relativa facilidad para distinguir entre encendido y apagado. Además, discernir entre estos dos estados es más barato, más preciso y más fiable. Por eso la mayoría de las luces de tu casa están encendidas o apagadas. Y ello depende de un simple interruptor (aunque es cierto que los reguladores de intensidad son cada vez más comunes y baratos).

En conclusión, construir un ordenador que reconozca los estados encendido y apagado (unos y ceros) es más sencillo que fabricar un dispositivo capaz de representar rangos. Es por este motivo que toda la información debe ser traducida a unos y ceros, las letras del ordenador, su alfabeto, por así decirlo.

Pero ¿realmente se puede representar información con unos y ceros?

Lo cierto es que estás leyendo este artículo. Y también es cierto que ha viajado hasta ti en forma de unos y ceros. Pero hagamos un inciso. Porque representar datos con solo dos letras no es algo exclusivo del ordenador. Ya se uso este sistema mucho antes de la invención de la primera computadora. Hablemos, pues, del telégrafo.

En 1829 el telégrafo eléctrico se convirtió en la primera tecnología de comunicación eléctrica. Pero el telégrafo no hubiera sido lo que fue de no ser por Samuel Morse, quien inventó el código que lleva su nombre. El código Morse o alfabeto morse, es un sistema de representación de números y letras que usa solo dos símbolos; dos estados; punto y raya. Sí: unos y ceros.

El alfabeto latino y los dígitos del cero al nueve se representan en clave morse como una sucesión de sonidos cortos (punto) y largos (raya). Por ejemplo, la letra A se representa como .- (punto y raya); por el contrario, si fuese raya y punto (-.) estaríamos hablando de la letra N.

Es especialmente famosa la señal en morse del mensaje de socorro S.O.S que incluye tres sonidos cortos (primera S), tres largos (O) y otros tres cortos (segunda S).

Así las cosas, es un hecho que la información se puede representar usando sólo dos símbolos (sistema binario). Por supuesto, se paga un pequeño precio por disponer de menos símbolos: la información ocupa más espacio. De igual forma, una palabra en inglés o castellano requiere casi siempre más caracteres que su equivalente en chino o japonés.

Pero ¿cuánto más espacio ocupa la información en unos y ceros? ¡Veámoslo con un ejemplo!

- En castellano: perro (5 caracteres)

- En inglés: dog (3 caracteres)

- En japones: 犬 (1 carácter)

- En binario: 01110000 01100101 01110010 01110010 01101111 (los caracteres «perro» ocupan 40 bits usando codificación ASCII)

Como se puede ver, menos caracteres implica más espacio para representar la información. Sin embargo, esto no supone ningún problema para el ordenador, ya que su capacidad para transmitir, procesar y almacenar información es inmensa y requiere un mínimo espacio.

Convirtiendo letras en números...

En el ejemplo anterior hemos visto que la palabra «perro» representada con ceros y unos requiere 40 posiciones para las 5 letras. Pero ¿de dónde sale este artificio? Vamos a ir por partes. Primero, vamos a ver qué es eso de la codificación ASCII.

ASCII es el acrónimo en inglés de American Standard Code for Information Interchange, es decir, Código Estándar Americano para el Intercambio de Información. Se creó en 1963. En la actualidad define 127 caracteres, entre los que se encuentran los dígitos del 0 al 9, las letras latinas mayúsculas y las minúsculas, entre otros.

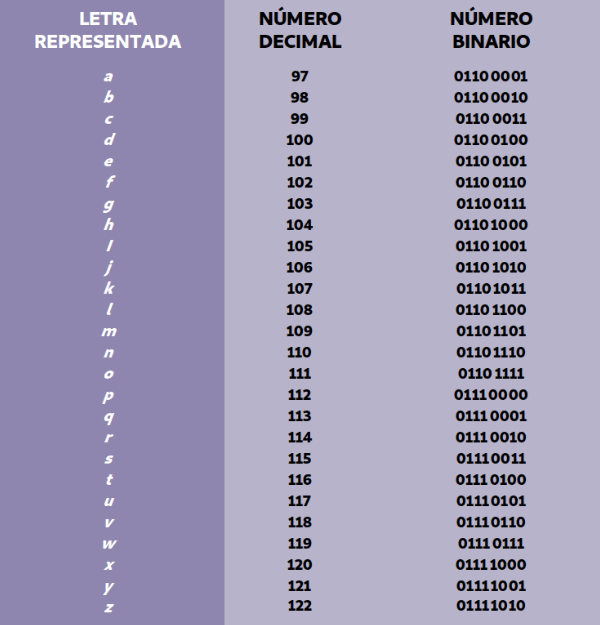

Vamos a ver los códigos de las letras minúsculas. De la a hasta la zeta son los siguientes:

Codificación de las letras latinas minúsculas a-z según el estándar ASCII

Codificación de las letras latinas minúsculas a-z según el estándar ASCII

¿Y por qué estos códigos? ¿No pueden ser otros? En efecto, podrían ser otros. Perfectamente. De hecho, existen otras codificaciones. Pero, al menos en el mundo occidental, es decir, para las lenguas basadas en el alfabeto latino, ASCII fue el estándar escogido. Las cintas VHS eran peores que las Betamax, pero las cosas hubiesen sido peor si conviviesen ambas.

Volviendo al asunto, ¿para qué sirve la codificación ASCII? Respuesta breve: para convertir letras en números. Por ejemplo, a la letra «p» le corresponde el número 112, que, expresado en base binaria, equivale a 01110000. Y aquí ya tenemos unos cuantos unos y ceros...

Pero ¿qué es eso de la base binaria? En pocas palabras, es una forma de representación numérica que solo usa dos dígitos: 1 (uno) y 0 (cero). Ahora bien, hagamos una pausa y recapitulemos antes de seguir avanzando.

¿Por qué querríamos convertir las letras en números? Muy sencillo: porque la mente del ordenador (el microprocesador) y el resto de su cuerpo (memoria, disco duro, tarjetas gráficas y de red...) solo piensan en números, por así decirlo. De tal manera que todo aquello que queramos almacenar o manipular con la computadora debemos convertirlo en números.

Y pensarás: «Pase que una palabra pueda convertirse en números, pero ¿cómo se convierte en números una fotografía, un sonido, un vídeo?». ¡Excelente pregunta! Y la respuesta es: troceando la imagen en cuadrados tan pequeños que solo contienen un color. A estos cuadros los llamamos elementos de la imagen o píxeles.

La palabra píxel también es un acrónimo del inglés, en concreto, de picture element o 'elemento de la imagen'. Si pudiésemos ordenar estos píxeles y asignar un número a cada uno de los colores posibles ya habríamos encontrado una forma de representar fotografías como números. Y, de hecho, así es como se hace.

Así pues, una vez que la información está convertida en números, ya es posible tratarla con el ordenador. Lo único que resta es representar esos números en forma binaria: unos y ceros.

Comparte nuestro artículo